januari 24, 2010

Eureqa: equation discovery med genetisk programmering

(For English readers: This blog post is available as a Google Translation from this Swedish text: Eureqa: equations discovery with genetic programming.)

För mer än 6 år sedan bloggade jag om equation discovery (att hitta ekvationer/samband givet en datamängd) och hittade några roliga system som jag då kollade in rätt mycket.

Nu är det dags igen: Eureqa är ett modernt equations discovery-system baserat på genetisk programming (närmare bestämt symbolisk regression) och det har ett fint GUI etc.

Eureqa blev världskänt i början av december förra året genom att Wired skrev en artikel om systemet och forskningen/forskarna bakom: Download Your Own Robot Scientist. Faktum är att jag laddade ner systemet och testade det lite men jag höll på på med andra saker.

De senaste dagarna har jag suttit med några enkla problem (dvs datafiler) för att lära känna Eureqa mer. Mer avancerade saker såsom dynamiska modeller (differentialekvationer) och komplexa ekonomiska system (såsom börskurser) tar jag tag i senare.

Jag tänker inte gå in på vad genetisk programmering är mer än att säga att det använder inspiration från biologin för att leta rätt på en lösning. Se vidare genetic programming (Wikipedia) för mer info och länkar.

Huvudprincipen för den variant av genetisk programmering som Eureqa använder är att man har

- en datamängd

- ett visst antal matematiska funktioner ("byggklossar")

- en relation mellan variabler som man vill studera

Eureqa hittar då givet variablerna och funktioner ett antal samband (lösningar, modeller). Med en "felfunktion" (error function) kommer diskrepansen mellan data och den skapade modellen att minska till ett så litet värde som möjligt, förhoppningsvis 0.

Här följer några kommentarer och ett och annat tips. Först beskrivs Eureqa, sedan lite mer om modelleringen med några exempel. Efter det länkar till några av de datafiler som används, och sist mer länkar om Eureqa.

Mycket kortfattat: Jag tycker Eureqa är ett riktigt trevlig och skoj system, tyvärr rätt mycket CPU-slukande för att min dator ska må riktigt bra. Men skoj.

Min vana trogen skapades även en My Eureqa page för länkar, filer och annat etc.

Installation

Programmet finns att ladda ner här.Tyvärr finns endast en Windows-version men det ska komma klienter för åtminstone Linux. Jag har inga större svårigheter att köra Eureqa under Wine förutom att det alltså tar väldigt mycket kräm när det bearbetar data.

Det installerades på min burk med följande kommando:

wine msiexec /i eureqa_full_0.7.7.msi

och kör det sedan med

wine "<installation path in Wine>/Eureqa.exe"

Mer om systemet

Eureqa har ett mycket trevligt GUI med olika tabbar för data, plottning/smoothing av data, modellering, start/stop och lösning. Dessa tabbar presenteras här kortfattat.* "Enter Data"

Man kan skriva in data som i ett enkelt spreadsheet à la Open Office Calc eller Excel (vad jag vet stöds inte formler etc). Det sätt jag använder är dock att skapa en text fil (ASCII) som består av följande:

- header med information om fälten. T.ex.

% | x y z |

där "%" är kommentar och de två "|" är avgränsare för variabelnamnen. Tänk på att det bör vara relativt korta namn annars kan det bli svårläst med mer komplexa uttryck.

- sedan data med mellanslag som separator.

För att hämta in en datafil används "File", "Import data...". Om det är fel i filen kommer mer eller mindre lättförståeliga felmeddelanden. Jag har inte testat så mycket att manuellt lägga in data via kalkylprogram men det ska gå.

* "Preview Data" (och smoothing)

I detta fönster man man se de olika värdena plottade i en x/y-graf. Man kan även göra en smoothing (vad jag förstår är det loess man använder), t.ex. om det är mycket brus för någon variabel.

* "Pick Modeling Task"

Här gör man själva modellen, dvs skapar förutsättningen för uttrycket. Se även nedan under "Modellering, några exempel".

- Search for a formula: Här skriver man formen för uttrycket, t.ex.

x1 = f(x2,x3).

- Using building blocks: Här väljs de funktioner ("byggklossar" som man vill att Eureqa ska testa. Normal vill man alltid ha "+","-","*","/", men sedan beror det lite på vad det är för typ av data. Intressant nog är "sin" och "cos" alltid med, vilket väl speglar utvecklarnas preferens för fysiska system. Eftersom de flesta av mina datamändger inte är fysiska system brukar jag börja med att ta bort sin och cos och i stället välja t.ex. square root, exponential och logarithm, eller helt enkelt endast börja med de fyra räknesätten.

Det finns ett flertal andra byggstenar, t.ex. minimum, maximum, Logistic, Gaussian, Gamma, Step och Sign, man inverser och hyperboliska varianter av trigonometriska funktionerna. På forumet antyds att det kommer flera i nästa version, t.ex. de booleanska AND, OR, XOR, samt att man ska kunna definiera egna varianter.

Det finns även andra saker på denna sida, t.ex. att välja Fitness metric och viktningen av datapunkterna.

Det går också att använda flera datorer till en körning. I "Use the following servers" väljer man eventuellt andra datorer som kör en Eureqa server. Detta har jag inte testat.

"Seed previous solution(s)": Här kan man skriva uttryck (formler) som en vink ("bias" till Eureqa att dessa är viktiga formler. Detta har jag inte kollat in så mycket.

* "Start/stop"

Här startar, stoppar och pausar man en körning. Förutom dessa knappar finns en mängd annan information om hur körningen går.

* "Solution Results"

Det är här man ser lösningen både som ett uttryck och även en graf hur bra lösningen är jämfört med de givna datapunkterna. Det är fascinerande att se den växa fram och lära sig.

Datamängden delas upp (automatiskt av Eureqa) innan körningen i två delar: träningsdata (train data) och valideringsdata (validation data). Sedan körs modellen på träningsdatan och valideras på valideringsdatan. Dessa två delar presenteras med olika färger här så man ser hur bra eller dåligt den valda modellen (uttrycket) passar. Mycket trevligt.

Olika statistiska metriker visas för respektive träning- och valideringdata:

- Fitness

- R-squared

- Correlation Coeff

- Mean Squared Error

- Mean Absolute Error

- Minimum Error

- Maximum Error

De flesta av dessa kan man använda som fitness metric i modelleringstabben.

I listan över lösningar ser man en handful lösningar som anses som mest intressanta, med den mest lovande överst. Denna lista växer dynamiskt hela tiden efter hand Eureqa hittar nya modeller. Om man klickar på en av modellerna visar både statistik och plottningen för den valda modellen. Dubbelklickar man på en formel kopieras den för att sedan klistras in i något finns program (t.ex. om man vill blogga om det).

Modellering, några exempel

Här en kort beskrivning om modelleringen. Till skillnad från traditionell "curve-fitting" så skriver man inte några matematiska uttyck som ska parametriseras, utan endast vilka variabler som ska vara med i uttrycket. För dessa variabler väljs om de överhuvudtaget ska vara med samt eventuell parameter. Eureqa hittar även olika konstanter, både "globala" och inom uttryck.Exempel med sinus

En av de första sakerna jag testade var att skapa en datafil med två kolumner (x och y) skapad på följande sätt (med Perl):

perl -le 'for (-100..100) { print $_/100, " ", sin(2*$_/100)+3}'

som skapar data för sambandet y = sin(2*x) + 3. De sparades i datafilen sin_formula.txt.

Eureqa hittar lösningen efter cirka 10-15 sekunder. Notera att x motsvaras av "x0" och y av f(x0) (eller x1):

f(x0) = 3 + sin(2 * x0)

Detta var alltså 201 datapunkter, men man behöver inte alls så mycket data för att Eureqa ska hitta en lösning.

En variant där man endast tar 20 slumpmässiga punkter är sin_formula_rand20.txt som är skapad genom att ta 20 punkter mellan 0 och 2*Pi:

perl -le 'for (1..20) { my $x = rand(2*3.14159); print "$x ", sin(2*$x)+3}'

Eureqa hittar 3+sin(2*x0) på cirka 30 sekunder. Det gick (denna gången i alla fall) lite långsammare eftersom det är färre punkter. Man ska dock komma ihåg att färre punkter gör att det är snabbare att kontrollera hur bra lösningen är.

Den viktigaste delen i modelleringen, förutom att hitta tillförlitlig data, är att hitta rätt byggstenar, dvs de matematiska funktioner som ska användas. Det bör göras med viss försiktighet och eftertanke: Om man väljer för många kan det ta väldigt lång tid och man kan får konstiga resultat. Väljer man för få så hittas inte en enkel lösning. Detta är en konst.

Fibonacci-serien

En annan skoj sak som man kan testa är tidsserier eller data som kan ses som tidsserier. T.ex. kan Eureqa hitta en formel för Fibonacci-serien? De 25 första talen i Fibonacciserien är: 1,1,2,3,5,8,13,21,34,55,89,144,233,377,610,987,1597,2584,4181,6765,10946.

För att göra detta till en lämplig representation - och som vanligt är representationen av problemet väldigt viktigt - är att man tar (tids)serien och lägger den i sekvens över flera variabler.

Låt oss anta att vi inte vet så mycket om denna serie, men anar att det finns en rekursivitet i serien, dvs att senare värden beror på de tidigare, normalt de omedelbart föregående (andra tidsserier, till exempel de ekonomiska kan ha andra beoenden såsom säsonger och veckodagsberoenden).

Här tas serien om fyra. Den första raden är 1,1,2,3, och sedan förskjuts serien för varje rad. Hela serien finns alltså i första kolumnen.

% | t1 t2 t3 t4 |

1 1 2 3

1 2 3 5

2 3 5 8

3 5 8 13

5 8 13 21

8 13 21 34

13 21 34 55

21 34 55 89

34 55 89 144

55 89 144 233

89 144 233 377

144 233 377 610

233 377 610 987

377 610 987 1597

610 987 1597 2584

987 1597 2584 4181

1597 2584 4181 6765

2584 4181 6765 10946

4181 6765 10946 17711

6765 10946 17711 28657

10946 17711 28657 46368

Nu kan vi modellera problemet i Eureqa på följande sätt:

- Formel: t4 = f(t1,t2,t3)

- Byggklossar: "+","-","*","/"

Det tar mellan 5 och 10 sekunder för Eureqa att hitta sambandet:

t4 = t3 + t2

Correlation Coefficient är 1.00000, R-squared är 1 och alla error är exakt 0 så det ser helt korrekt ut.

Detta är skoj!

Man kan här notera att egentligen behövde vi ju bara de tre första variablerna t1, t2 och t3 men jag valde att ta med den extra kolumnen t4 för att inte fuska för mycket. En annan sak att notera att det är viktigt att titta på Correlation Coefficient och R-squared samt Error för att se hur bra lösningen är.

Nu kan man göra lite mer roliga saker. Given en lite större datamängd (fib_38.txt) med 38 värden kan vi kolla om Eureqa hittar några andra samband, t.ex. mellan endast två variabler t1 och t2, dvs mellan ett värde och endast de närmast föregående. Här lägger jag till funktionerna "exp", "sqrt" och "log".

Här är några samband som hittades i flera olika körningar. Samtliga dessa har en fitness error på 0.000 (det som i lösningstabben kallas "Error") och correlation coefficient på 1.0

f(t1) = 1.61803*t1

f(t1) = 1.61803*t1 - 0.472137/t1

f(t1) = 1.61803*t1 - 1.67999/exp(t1)

f(t1) = 1.61803*t1 - 1.67999/exp(t1)

f(t1) = 0.809017*t1 + 0.809017*sqrt(t1)*sqrt(t1) - 0.470881/t1

f(t1) = 1.61803*t1 + 0.221196/(t1*t1 - 1.61571*t1 - 1.70552)

f(t1) = 1.61803*t1 + -3.39888*log(t1)/exp(t1*t1 - 1.69947)

f(t1) = (1.61803*t1*t1 - 0.459213)/t1

f(t1) = 1.61803*t1 - 0.440428/(t1 - 0.440428/(1.61803*t1))

f(t1) = 1.61803*t1 - 0.3884/(t1 - 0.354305)

Notera att Eureqa har identifierat konstanten 1.61803 i flera av ovanstående lösningar vilket är väldigt nära phi, dvs "gyllene snittet" (golden ratio) = (1+sqrt(5))/2 ~ 1.6180339...). phi är precis förhållandet mellan två intilliggande Fibonaccital, så det är ju inte konstigt att Eureqa hittade detta samband. Se Fibonacci number på Wikipedia och Encyclopedia of Integer Sequences:A000045 för mycket mer info om detta.

Man kan säkert hitta andra matematiska konstanter om man letar vidare. Plouffe's Inverter är en guldgruva för sådant. T.ex. här är en sökning på konstanten 1.61803. Tyvärr är det väldigt många träffar eftersom det är så liten precision på talet.

Formeln f(t1) = 1.61803*t1 är alltså en approximering av nästa tal i Fibonacci-serien, dvs F[n+1] = phi*F[n] (avrundat till heltal).

Ett mera avancerat exempel är om Eureqa månne kan hitta den slutna formeln för Fibonaccital, dvs

F(n) = (phi^n - (1-phi)^n)/sqrt(5)

För detta krävs en ytterligare parameter i datafilen, nämligen n, dvs index för raden. Så här ser filen ut nu (fib_50.txt"), utökat till 50 rader. Den första kolumnen är alltså index.

% | ix t1 t2 t3 t4 |

1 1 1 2 3

2 1 2 3 5

3 2 3 5 8

4 3 5 8 13

...

48 4807526976 7778742049 12586269025 20365011074

49 7778742049 12586269025 20365011074 32951280099

50 12586269025 20365011074 32951280099 53316291173

Jag vet inte riktigt hur stora tal som Eureqa kan använda, men det saknas i alla fall stöd för arbiträr precison.

När jag skapat filen testades först med samtliga variabler:

t4 = f(ix,t1,t2,t3)

Då kommer lite mer avancerade förslag än tidigare körning, samtliga med Error 0 och correlation coeff på 1.0000 (dock inte med Maximum error 0), några av dem innehåller n, dvs index.

f(ix, t1, t2, t3) = sqrt(1.61803*t2*t3) + (t2*sqrt(t3) - t2*t2)/(sqrt(t3) - t2)

OK, nu till problemet om den slutna formeln

Formel: t1 = f(ix)

Funktioner: +,-,*,/, sqrt

Det vi vill ha är alltså något som liknar:

(phi^n - (1-phi)^n)/sqrt(5)

eller snarare den numeriska motsvarigheten

f(ix) = (1.61803^ix - (1-1.61803)^n)/2.2361

= (1.61803^ix - (-0.61803)^n)/2.2361

= 0.4472071911*1.61803^ix - 0.4472071911*(-0.61803)^ix

(Den tredje varianten hittades via ett matematikverktyg.)

Intressant nog började Eureqa med lösningar där endast ix upphöjt till stora tal (t.ex. 18) samt addition, multiplikation med konstanter. Efter ett tag började experimenten med sqrt, men den körningen hittade inte skoj på många minuter så jag stoppade den.

För att komma runt detta testade jag "hints", dvs "Seed previous solution(s)" på "Pick Modeling Task"-tabben, genom att skriva 1.61803^ix samt sqrt(5). Då kom följande lösningar efter liten stund. De har alla korrelationskoefficient på 1, Error på 0 men stora Maximum Error.

f(ix) = ix + 4*ix*ix*ix + 0.0256922*ix*1.58422^ix

f(ix) = 0.445386*ix + 0.445386*1.61817^ix

f(ix) = 0.0893707 + 0.399785*sqrt(1.61804^ix) + 0.447094*sqrt(1.61804^ix)*sqrt(1.61804^ix)

f(ix) = 2*ix + 0.447097*1.61804^ix

f(ix) = 0.611078*sqrt(1.62499^ix) + 0.447094*1.61804^ix - 127.933

Jag undrar dock hur "naturligt" det är för Eureqa att testa formler på formatet "konstant^variabel", så detta anser jag vara lite fusk. Däremot, om det skulle gärna mer seriösa experiment är denna typ av hintar vettiga. Då anger man vissa samband som grund, ett "alfabet" att bygga vidare på. Jag tror att mer stöd för detta kommer i senare versioner.

Efter detta - ska vi säga misslyckande - skippade jag hintarna och lade på funktionerna "exp", "sin", "cos" och då hittades detta samband och flera liknande, som jag faktiskt inte vet hur det ska tydas. Vad är 0.481188 för något tal i detta sammanhang?

f(ix) = 0.447755*exp(0.481188*ix) - 0.481188*ix*ix*ix

Om man däremot lägger till funktioner "power" (och tar bort alla hintar) så kommer lösningar på formen konstant^ix väldigt snabbt (dvs inom en minut eller så), t.ex.

f(ix) = 32.1653 + 0.446572*1.61809^ix

Där vi möjligen kan ana phi i konstanten 1.61809.

En kommentar om "power": När man väljer den i funktionslistan kommer meddelandet Tip: integer powers are implemented automatically with the multiply operation. This more general power operator may not be needed for modeling the dataset.. Här har vi tydligen ett fall där "power" behövs.

Andra lösningar i olika körningar:

f(ix) = 1.61808^(ix - 1.67492)

f(ix) = 0.0893756 + 0.399799*1.27202^ix + 0.447099*1.27202^ix*1.27202^ix

f(ix) = 1.61804^(ix - 1.67287) + 1.61804^(0.478442*ix - 0.800371)

f(ix) = 1.26564^(2*ix - 1.26564) + 2*ix - 1.26564

f(ix) = ix + 0.447144*1.61804^ix

(Jag har inte analyserat vidare eventuella matematiska samband...)

Notera att även om det är 0 i Error och 1 i korrelationskoeffient så kan det vara stora fel när man pumpar i konkreta värden.

En intressant lösning är följande där man möjligen kan skymta de viktiga beståndsdelarna i den slutna formeln:

- sqrt(5) ~ 2.2361

- 0.4472071911*1.61803 (från tredje varianten av den sökta formeln)

f(ix) = 2.23642*ix + 0.447144*1.61804^ix

Mer komplexa varianter:

f(ix) = 0.447144*1.61804^ix + 2.61804*ix*ix - (ix*ix)^(ix - 48.6408) - 48.6408*ix

Efter detta avslutade jag testet p.g.a. tidsfaktorer.

Slutsats: Vi hittade alltså inte formeln under dessa experiment, men vissa av sambanden kanske kan vara intressanta att studera vidare. Och så lärde vi oss det där med "power". En annan sak detta visar är att man kan vara tvungen att starta om flera gånger för att få mer aptitliga lösningar.

Derivata

Som nämnts några gånger tidigare så har jag inte labbat så mycket med dynamiska modeller, ävenom Eureqa skapats för detta ändamål. En av anledningarna är att jag inte har så bra data tillgänglig, en annan är att de mer intressanta körningarna kan ta lång tid, i vissa fall många timmar; "över natten" är ett uttryck som används några gånger i skrifterna.

Som videon (se Eureqas hemsida för länk) visar finns det möjlighet att använda derivata på följande format:

D(x1,t) = f(x1,x2,t)

och även i högerledet

D(x1,t) = f(x1,x2,D(x2,t))

Andra derivatan skrivs på följande sätt:

D(x1,t,2) = f(x1,x2,t)

Man ska dock tänka på att med derivata så krävs en preprocessing som kan ta mycket lång tid.

Andra modelleingsexempel beskrivs nedan.

Datafiler

Här är några av de datafiler som jag testat. För det mest är det enklare saker, och inte någon dynamisk data. De läses in med "File", "Import data...". Datafilerna finns även att tillgå på My Eureqa page.- gelman.csv: Linjär regressionsexempel.

Data från Andrew Gelman's bloggpost Equation search, part 1, Equation search, part 2. Problemet beskrivs även lite mer i A linear regression example, and a question.

Skriv följande i Pick Modelling Task:

y = f(x1,x2)

och lägg till "sqrt" som funktion.En lösning är mycket riktigt

f(x1,x2) = sqrt(x1^2+x2^2)

Med en korrelationskoefficient på 1.0 (och det är alltså bra). - planets.txt: Keplers tredje lag

Detta exempel baseras på DTREG, ett annat symboliskt regressions-verktyg. Här hittas Keplers tredje lag baserat på den data som Kepler hade. Keplers tredje lag är:

Period^2 = Distance^3

Formel:

Period = f(Distance)

Funktioner: Skippa sin och cos, lägg till square root, exp och logarithm.Eureqa hittar rätt snabbt samband såsom:

Period = sqrt(Distance)*Distance

och det går snabbt. - odd_parity.txt

En test på "paritet", men det funkar inte eftersom Eureqa än så länge saknar booleanska operatorer såsom OR, AND och XOR. Det ska komma "snart". - sin_formula.txt

Se ovan. - sin_formula2.txt

Se ovan. - sqrt_formula.txt

Skapad så här:

perl -le 'for (-100..100) { print $_/100, " ", sqrt(abs(2*$_/100))+3}'

Glöm inte att lägga till sqrt, abs och lite andra funktioner. - iris.txt: Iris data

Iris är ett standardproblem (-datamängd) inom machine learning och traditionell multivariat statistisk analys. Se Iris flower data set (Wikipedia) för mer information. Kortfattat handlar det om att klassifiera tre olika blomtyper (Iris setosa, Iris virginica and Iris versicolor) med avseende på fyra attribut: (Sepal Length, Sepal Width, Petal Length, Petal Width). 50 mätningar gjordes för respektive blomtyp.Jag tänkte att det skulle vara skoj att testa det med Eureqa också. Tyvärr klarar inte Eureqa att hantera kategorier (dvs strängrepresentation) så jag döpte om dem till "1", "2", samt "3" vilket troligen förvirrar Eureqa. En standardlösning för visssa typer av analysverktyg/-metoder som inte klarar kategorier är att i stället använda tre binära variabler som representation för de tre kategorierna. Men jag vet inte hur man får in sådant i Eureqa.

Jag började med att representera attributen som

sepallength, sepalwidth, petallength, petalwidthmen det blev så trångt i lösningsfönstret att jag ändrade till kortnamnensl, sw, pl, pw.Problemet skrivs på följande sätt

class = f(sl, sw, pl, pw)

Första körningen, med standarduppsättningen "+","-","*","/" samt "sin" och "cos" gick inte alls bra. Men när - som experiment - jag lade till funktionerna "minimum", "maximum" och "sqrt" så hittas följande rätt snart

class = f(sl,sw,pl,pw) = max(1,pw + 2.20/sw)

med en error på 0.179, fitness på -0.18, correlation coeff på 0.96, mean squared error 0.04. Traditionella metoder inom data mining/machine learning såsom beslutsträd brukar ligga ungefär där med 5-10 felklassificerade instanser.Efter lite mer tuggande kommer några bättre lösningar.

error 0.129:

f(sl, sw, pl, pw) = 0.975279 + min(0.624122*pw*pw, 2.02407)

error 0.124:

f(sl, sw, pl, pw) = 0.926007 + min(max(0.63846*pw*pw, 0.0735181), 2.07556) Jag är inte nöjd med detta eftersom min och max inte är så naturliga i sammanhanget och jag har inte analyserat vidare ramifikationerna av detta. Men det är ett roligt experiment. Man skulle kunna gå vidare och kontrollera vad som händer om man representerar de tre kategorierna med talen 100, 200, 300 istället, eller lägger till andra funktioner såsom sign etc.

Som jämförelse kan nämnas att andra metoder (t.ex. via machine learningverktyget Weka) ger följande resultat, båda med ett antal felklassifikationer.

J48 (beslutsträd):

petalwidth <= 0.6: Iris-setosa (50.0)

petalwidth > 0.6

| petalwidth <= 1.7

| | petallength <= 4.9: Iris-versicolor (48.0/1.0)

| | petallength > 4.9

| | | petalwidth <= 1.5: Iris-virginica (3.0)

| | | petalwidth > 1.5: Iris-versicolor (3.0/1.0)

| petalwidth > 1.7: Iris-virginica (46.0/1.0)

JRIP (regelbaserad method):

(petallength <= 1.9) => class=Iris-setosa (50.0/0.0)

(petalwidth >= 1.7) => class=Iris-virginica (48.0/2.0)

(petallength >= 5) => class=Iris-virginica (5.0/1.0)

=> class=Iris-versicolor (47.0/0.0)

Se även min My Weka page för mer saker om Weka.

- Sunspots.txt: Sunspots

Solfläcksdata är ett annat standardproblem inom statistik och tidserieanalys. Tyvärr är jag lite osäker på vad denna data kommer ifrån, men det ska mätning av solfläckar på årsbasis. Så ta följande med en viss nypa salt och se det som ett generellt experiment.Detta är alltså en tidsserie med 11 "förskjutna" variabler.

Formel

t11 = f(t1,t2,t3,t4,t5,t6,t7,t8,t9,t10)

Funktioner: +,-,*,/, sin, cosNotera att jag lät sin och cos vara med men de användes inte under den cirka halvtimmen jag körde (förutom några tidigare lösningar som förkastades snabbt).

Efter ett par minuter var följande med i listan över aktuella lösningar (avrundat till 2 decimaler):

Error: Solution

0.215: 0.65*t10 + 0.66* (t10 / (0.32+0.08*t8)

0.237: 7.20+1.34*t10 - 0.58*t9

0.261: 1.39*10-0.54*t9

0.302: 1.91*t10-t9

0.307: t10-0.19*t9

0.342: 0.84*t10

0.400: t10

Ingen av lösningarna är speciellt bra. Vi ser dock att t10 - inte förvånande - alltid är med, ibland t9 och vid ett tillfälle (det bästa) med t8 vilket visar att det finns någon form av beroende av tidigare värden.

- sin_formula_rand20.txt

Skapad med följande:

perl -le 'for (1..20) { my $x = rand(2*3.14159); print "$x ", sin($x)+exp($x)+3}'

Hittar följande snabbt:

3 + exp(x0) + sin(x0)

Testar genom att skippa sin(), men låter cos() vara kvar. Det tar en stund, sedan hittar den följande

3.00 + exp(x0) + cos(1.57-x0)

- boyles_law.txt: Boyles gaslag

Se mer på Wikipedia Boyle's law.Detta är en klassiker i sammanhanget (dvs equation/scientific discovery), från boken Langley et.all Scientific discovery (ISBN: 9780262620529, länk till Bokus), sidan 82. Boken beskriver hur systemet BACON angriper problemet. BACON är ett system med liknande intentioner som Eureqa men använder en annan teknik. Boken är för övrigt mycket intressant.

Eureqa hittar relativt snabbt samtliga samband (vid var sin körning):

PV = P*V

V = PV/P

P = PV/V

Corelation coeff är 1 och mean error i princip 0.Intressant nog kommer under körningen

VP=f(V,P)även andra samband efter en stund:

f(V, P) = (V*P*cos(-1*P - 1.36791) - V*P*P)/(cos(-1*P - 1.36791) - P)

- fib_25.txt: Fibonacci

Se ovan.

- fib_35.txt

Se ovan. - catalan.txt: Catalan-talen.

Har inte hittat något skoj hittills, men ska nog leta vidare...

- not_squares.txt

Tal som inte är kvadrater. Hittade inget skoj. - primes.txt: Primtal

Detta är också en tidsserie-variant med 10 variabler för att se om något skoj samband hittas. Även här får man leta vidare. - primes_with_index.txt: Primtal med index (dvs ordningstalet för primtalet)

Se ovan om primes.txt - p4_gap.txt: Polynom

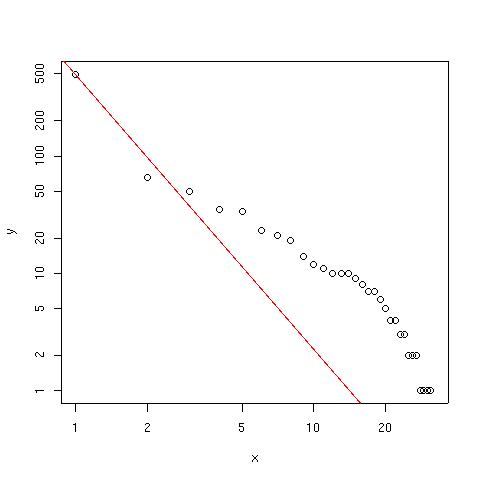

Detta är ett av exempelproblem från JGAP (ett generellt genetisk programmingssystem i Java) där problemet är att hitta polynometx^4 + x^3 + x^2 - x.Detta tog cirka 30 sekunder att hitta denna funktion i Eureqa. Notera att jag tog bort "sin" och "cos".

Som jämförelse kan nämnas att JGAP-versionen tog cirka 12 minuter (vid första och enda körningen), men det är inte en rättvis jämförelse eftersom Eureqa är optimerat för denna typ av körningar. Uppdatering: . Jag noterade att anledningen till att det tog så lång tid i JGAP var att det inte fanns några operatorer för Add (+) eller Subtract (-) vilket ju gör problemet mycket svårare. När dessa lades till (samt Sine och Exp togs bort) tog det cirka 10 sekunderi JGAP. JGAP är helt klart ett intressant system för genetisk programmering.

- p4_1.txt: Polynom

Jag skrev ett litet program som skapar slumpdata för polynom på formenx^n+n^(n-1)+...n^2+x^1+x. Sådan problem kallar jag förp(n)nedan.Detta är alltså

p(4). Det tog Eureqa cirka 20 sekunder att hitta

p(4) = x^4 + x^3 + x^2 + x

baserat på 30 punkter x,y inom intervallet -5.0..5.0. - p10_1.txt Polynom P(10)

Däremot var det lite problem med p(10) över intervallet -2.5..2.5 och 100 punkter. Jag startade om ett antal gånger efter att ha väntat - ovetenskapligt nog - "några minuter .Rätt tidigt hittades x^10+x^8+x^7 men sedan tog det stopp

och Eureqa började labba med x^12, t.ex.(x^12-x^2)/(x^2-x).En trolig förklaring till detta är att Eureqa straffar flera termer till förmån för färre.

Jag startade om och ändrade Fitness Metric till "Maximum Error" (på tabben "Pick Modeling Task"). Efter cirka 6 minuter hittades

0.73*x+x^2+x^3+x^4+x^5+x^6+x^7+x^9+x^9+x^10

med ett Maximum error på 1.76. Correlations coefficienten är 1.0000 vilket ju är bra.Lösningen

(x^12-x^2)/(x^2-x)

har ett mindre felvärde för den datamängd jag testade, det var ju bara 100 punkter, så en del kan förklaras utifrån slump.Jag tröttnade efter typ 20 minuter.

- p6_1.txt: p(6)

- p7_1.txt: p(7)

- circle_1_fixed.txt: Cirkel

Detta är ett av exemplen till Eureqa, som finns att laddas ner här. Tyvärr är de i ett konstigt format så jag var tvungen att snygga till dem lite, härav namnet "_fixed.txt".

Formel:

x3 = f(x1,x2)Hittar lösningen 4*sin(x1) på 20 sekunder.

Formal:

x2 = f(x1,x3)

Hittar lösningen 4*sin(x1) på 20 sekunder.Testar nu derivata:

Formel:

D(x3,x1) = f(x1,x2)

Lösningen verkar vara

dx3/dx1 = x2

Testar formeln

D(x3,x2) = f(x1,x2)

Lösningen är 0 som Eureqa hittar omedelbart.Formeln

D(x2, x1) = f(x1, x3)

ger lösningenx3.

Mer om Eureqa

Här är en samling länkar om Eureqa.- Download page

- User Guide (PDF)

- Discussion Group (google group)

- FAQ

- Video: "Introduction to Eurequa" finns via Eureqa-sidan, och även på Youtube: Introduction to Eureqa (1/2) samt Introduction to Eureqa (1/2)

- Hod Lipon och Michael Schmidt är utvecklarna av Eureqa. Deras Science-artikel Distilling Free-Form Natural Laws from Experimental Data, supplemental materials (PDF). Mer finns på Sciences sajt Distilling Free-Form Natural Laws from Experimental Data, Supporting Online Material, med bl.a. den data som används invar_datasets.zip. Som nämndes ovan är datafilerna konstiga (i alla fall i min miljö) och måste fixas till.

Mer om symbolisk regression som är den metod Eureqa använder: Symbolic regression (Wikipedia)

* Andra artiklar om Eureqa:

- Wired: Download Your Own Robot Scientist

- Guardian: 'Eureka machine' puts scientists in the shade by working out laws of nature

- Physorg.com: Eureqa, the robot scientist (w/ Video)

- Andrew Gelman (bloggar på "Statistical Modeling, Causal Inference, and Social Science"): Equation search, part 1, Equation search, part 2.

Posted by hakank at 09:16 FM Posted to Dynamiska system | Machine learning/data mining | Pyssel | Statistik/data-analys

juni 06, 2008

Blogglunch söndagen den 15/6 kl 13.00 samt Markovgenererade bloggträffsammanställningar

Zyrenna-Åsa manar till Blogglunch söndagen den 15/6 kl 13.00, naturligtvis på restaurangen Kin Long. Meddelena Åsa om du tänker komma.

Med anledning av en semantisk förrvirrning angående tidens riktning i en första version av kallelesen skriver hon i kommentarsflödet:

Någon borde testa [att skriva refererat för framtiden]. Skriva referatet i förväg och sedan jämföra med utfallet.

Sammanställningar om redan hända bloggträffar har gjorts. Men att skapa sammanfattningarna innan? Detta kändes som en utmaning!

Eftersom jag är alldeles för lat för att fantisera fram diskussionerna på en hel bloggareträff gjordes det näst bästa: utgick från de redan skriva sammanfattningarna. Det blev det Markovgenerering - inte helt förvånande för den som följt med ett tag. Se t.ex. Generering av Nobelpris-motiveringar (Markov såklart) för mer om Markovgenerering av texter.

Det aktuella programmet som skapar bloggträffsammanfattningar är Markovgenererade bloggträffsammanfattningar.

Om texten inte upplevs vara helt korrekt svenska, föreställ då att författaren är smått förvirrad, berusad eller skriver aningen för snabbt . Eller helt enkelt är poetiskt kryptisk, en kryptopoet .

Posted by hakank at 08:43 EM Posted to Bloggmiddagar | Språk | Statistik/data-analys | Comments (1)

oktober 28, 2007

Svar på Hakkes frågor angående monovokala ord

Den alltid nyfikne hakke skickade följande mail till Jonas Söderström och mig häromdagen. (Mailet är trivialt redigerat.)

Det går ju inte att kommentera den här gamla godingen :( Ooo, så långa ordSå jag får mejla kommentaren istället :)

/Håkan (hakke)

Vissa saker man läst sitter liksom kvar i hjärnan som en lös liten

skruv, som ibland vickar till och gör sig påmind. Dit hör det här

inlägget, bland annat för att det var här jag upptäckte bloggarna men

också på grund av dess språkglädje.Nyss stötte jag på ordet "kulturutbud" i en text. Det är inte särskilt

lättläst, en egenskap det troligen delar med många andra monovokala

ord.Håkan Kjellerstrand hade ju vänligheten att publicera följande lilla

lista över förekomsten av monovokala ord för var och en av svenskans

vokaler:

Vokal: antal ord

----------------

a: 3137

e: 791

i: 1299

o: 960

u: 625

y: 192

ä: 590

å: 280

ö: 272

Några saker jag blir nyfiken på är:

Efter kom sedan tre (3) frågor som av besvaras (eller åtminstone bekommenteras) var och en i det nedanstående. Notera att ordlistan som användes för att skapa ovanstående förekomstfördelning är äldre i relation till den ordlista som används i dessa svar.

Hakkefråga 1. Vilka är de längsta fem monovokala orden för varje vokal?

Svar fråga 1.

Här är de inte bara de fem utan även de sex längsta ord för respektive monovokal . Ordlängden visas efter ordet. Not: Det kan finnas flera ord med samma ordlängd som den minst långa ordlängden för respektive vokal. Programmet visar då endast att det blir exakt sex stycken ord (och slumpmässighetens underbara men samtidigt starkt underskattade men starkt påverkande hand styrde exakt vilka som visas).

Vokal a:

brandalarmapparat: 17

andrahandsmarknad: 17

partssammansatt: 15

branschanpassad: 15

brandhandgranat: 15

tandspacklarnas: 15

Vokal e:

referensfrekvens: 16

frekvensmeterns: 15

telexreglemente: 15

referenselement: 15

meddelelsemedel: 15

pendelfrekvens: 14

Vokal i:

lindningsriktning: 17

tillfriskningstid: 17

lindningsstigning: 17

drivningsriktning: 17

visningsspridning: 17

stigningsriktning: 17

Vokal o:

motorfordonskontroll: 20

kontrollprotokoll: 17

domstolsprotokoll: 17

torvjordskompost: 16

fordonskontroll: 15

kontrollmottolk: 15

Vokal u:

ursprungspunkt: 14

djupbrunnspump: 14

sunhultsbrunns: 14

grundstruktur: 13

sunhultsbrunn: 13

kugghjulspump: 13

Vokal y:

skyddshytt: 10

styckfryst: 10

krymptryck: 10

tryckstyrd: 10

plymprydd: 9

frysskydd: 9

Vokal å:

stålspåntlås: 12

språngstråk: 11

tvångsvård: 10

stånggång: 9

nålsprång: 9

ståltråds: 9

Vokal ä:

rättshjälpsnämnd: 16

kärrsnäppsägg: 13

vändskärsfräs: 13

rännhärdsjärn: 13

skräntärnsägg: 13

ändskärsfräs: 12

Vokal ö:

mörkrödglöd: 11

bröstsköld: 10

förströtts: 10

bröstmjölk: 10

slöjdbjörk: 10

bröstböld: 9

Hakkefråga 2. De korta orden intresserar mig inte särskilt mycket. Det skulle vara intressant att se motsvarande sammanställning begränsad till de ord där det finns minst 3, 4 respektive 5 vokaler. Jag gissar att fördelningen mellan ordrikedomen per vokal då också kan komma att förändras något. Kanske blir ledningen för a och i ännu tydligare?

Svar fråga 2

Först kommer den totala fördelningen av antal vokaler per ord som har

minst 2 vokaler för att få en känsla för vad som kommer:

Fördelning av antal vokaler per ord:

2: 9868

3: 3215

4: 539

5: 60

6: 6

Sedan med hakkes föreslagna begränsningar om minst v vokaler.

Vanligaste bokstaven (minst 2 monovokaler):

a: 7377

e: 2080

i: 1612

o: 1275

u: 436

ä: 410

ö: 253

å: 196

y: 49

Vanligaste bokstaven (minst 3 monovokaler):

a: 2447

e: 717

i: 350

o: 229

u: 64

ä: 9

å: 2

ö: 2

Vanligaste bokstaven (minst 4 monovokaler):

a: 354

e: 179

i: 38

o: 33

u: 1

Vanligaste bokstaven (minst 5 monovokaler):

a: 42

e: 16

i: 4

o: 4

Vanligaste bokstaven (minst 6 monovokaler):

e: 4

a: 1

o: 1

Det finns inga ord i ordlistan med 7 eller fler monovokaler.

För fullständighetens skulle visas här även fördelningen av ordlängden (för ord med minst 2 monovokaler):

3: 22

4: 300

5: 1226

6: 2486

7: 2964

8: 2744

9: 1886

10: 995

11: 517

12: 299

13: 151

14: 62

15: 16

16: 6

17: 13

20: 1

Hakkefråga 3. Undrar om fördelningen ändras över tiden? Sedan listan skapades har det ju kommit en ny version av saol.

Svar (eller snarare kommentar till) fråga 3

Hakke har troligen en poäng att ovanstående beskrivna fördelningar förändras över tiden. Det är dock utanför mitt experimenterande eftersom jag inte använder SAOL utan Den stora svenska ordlistan (eller snarare ett derivat av den ordlista man kan ladda ner här och om vilket kommenteras något mer här nedan).

Svar på anticiperad följdfråga: Nej, jag har inte sparat olika DSSO-versioner för denna typ av jämförelse.

Några vidarekommentarer

För ett antal (cirka 2) månader sedan förnyades monovokaldiskussionen på Blind Höna, i Ooo, så många o:n! Monovokal toppnotering tangerad (där mina findings bygger på samma ordlista som ovanstående analyser). Se även Söndagspyssel där den ursprungliga monovokaldiskussionen fortsatte att diskuteras.

DSSO-listan är samma ordlista som man hittar på http://sv.speling.org/files/ (det görs en omdirigering till DSSO-sajten). Denna ordlista har även används i andra språk-/ordprojekt, t.ex.

* Visa ordklasser (presenteras i Svenska ordklasser samt gissning med hjälp av ordsuffix)

* Consonants Away (presentation i Consonants Away)

* samt ett gäng andra s.k. useless-projekt.

Posted by hakank at 09:50 FM Posted to Språk | Statistik/data-analys | Comments (7)

september 26, 2007

Videoföreläsning om R (del 1, en kort introduktion)

Decision Science News (en av favoritbloggarna kring beslutsteori, dataanalys etc) har nu börjat med videoföreläsningar i dataanalysverktyget R. Se vidare R video tutorial number 1. Det är en kort introduktion men kan vara början på något trevligt.

Som presentatören säger så rekommenderas en bok (eller två) i R (eller det mycet snarlika språket S). En förhoppningsvis fullständig lista över relaterare böcker finns här. Några av mina favoriter är:

* William N. Venables, Brian D. Ripley. S Programming (ISBN: 9780387989662). En introduktion för den som vill gå in på djupet i själva R-språket (eller S).

* William N. Venables, Brian D. Ripley: Modern Applied Statistics with S, 2002 (ISBN: 9780387954578). Det är en relativt avancerad bok men innehåller mycket matnyttig information, många tips och funktioner.

Se även Några videoföreläsningar om statistik, sannolikhet och data mining.

Posted by hakank at 10:31 EM Posted to Statistik/data-analys | Video podcasts | Comments (1)

augusti 21, 2007

Upptäcka kraftiga förändringar i tidsserier (changepoint detection)

I Recension av Keith Devlin, Gary Lorden: The Numbers Behind Numb3rs: Solving Crime with Mathematics nämndes att kapitel 4 When does the Writing First Appear on the Wall? - Changepoint Detection var det som gav mig mest ny information. Så naturligtvis har jag lekt lite med detta.

I Numb3rs-avsnittet Hardball (tredje säsongen) nämner Charlie Epps (matematikern i Numb3rs) Shiryayev-Roberts metod i samband med baseballresultat för att upptäcka förändringar i tidsserier, men den är "slightly more technical to describe" än den metod som E.S. Page skapade varpå man beskriver Pages. (Kapitlet är troligen skrivet av Gary Lorden eftersom han tidigare skrivit om changepoint detection. Och troligen är det E.S. Page paper "A test for a change in a parameter occurring at an unknown point" som avses. Men ingen av detta står uttryckligen i boken. Gnäll^2.)

Först presenteras kortfattat Pages metod, följt av min R-implementation. Hur väl den följer Page har jag faktiskt inte lyckats röna ut. Här används emellanåt "förändringspunkt" i stället för "changepoint"; "breakpoint" används också nedan.

Introduktion och beskrivning av Pages metod

En specifik händelse inträffar eller inte under en dag. Om den inträffar markeras detta i en tidsserie med 1, annars 0.

Bokens exempel är en händelse som inträffat c:a 1 gång per månad, dvs sannolikheten är 1/30. Sannolikheten för att händelsen inte inträffar är således 1-1/30 = 29/30. Detta är normalfallet. För att citera bokens lättsamma exempel på några sådana händelser som kan tänkas inträffa (i genomsnitt) en gång i månaden:

Examples abound - a New Yorker finds a parking place on the street in front of her apartment, a husband actually offers to take out the garbage, a local TV news show doesn't lead off with a natural disaster or violent crime, and so on.

Mer seriöst (och det beskrivs mer sådant i kapitlet) skulle man kunna tänka sig någon form av olycka eller sjukdomsfall som rapporteras varje dag. Notera att vi här endast arbetar med om händelsen inträffar eller inte; det är inte frågan om antalet olyckor etc. (Se i slutet av denna anteckning för hur man arbetar med numeriska värden.)

Vi vill nu upptäcka ("detektera") om/när det blir en drastisk förändring i hur ofta dessa händelser inträffar, t.ex. att de plötsligt inträffar i genomsnitt en gång i veckan i stället, dvs med sannolikheten 1/7. Låt oss kalla detta för extremfallet. Sannolikheten för att en extremhändelse inte inträffar en gång i veckan är således 1 - 1/7 = 6/7.

Falsklarm: Problemet med händelser som inträffar i genomsnitt en gång i månaden är att två händelser som i genomsnitt händer en gång i månaden faktiskt kan inträffa två intilliggande dagar eller klustra sig på andra sätt. Vi vill undvika falsklarm när slumpen gör det den ska (nämligen att slumpa).

Ett metod att minska antalet sådana falsklarm är alltså E.S. Pages metod som boken går igenom med ett exempel. Här har jag tagit beskrivningen från boken rakt av.

Det finns ett numeriskt index S som "spårar" aktiviteten dag för dag.

* Initialt är S = 1.

* För varje dag uppdateras värdet enligt följande:

- om händelsen inträffar under dagen: multiplicera S med sannolikheten för att

normalfalletextremfallet inträffar delat med sannolikheten förextremfalletnormalfallet inträffar, här (1/7) / (1/30) = 30/7 = 4.286 - om händelsen inte inträffar under dagen: multiplicera S med sannolikheten för att

normalfalletextremfallet inte inträffar delat med sannolikheten för attextremfalletnormalfallet inte inträffar, här (6/7) / (29/30) = 0.8867

- om S efter en sådan uppdatering blir mindre än 1: återställ S till 1

* Till slut finns ett gränsvärde för när vi ska varna för att en s.k. changepoint har inträffat. Om S överstiger detta gränsvärde anses händelserna nu komma en gång i veckan (extremfallet). I boken har man satt 50 som detta värde. (Det förs en liten diskussion hur olika gränsvärden påverkar hur väl man kan upptäcka förändringarna, men det går jag inte in på här.)

Bokens exempel

Boken använder följande händelsesekvens som exempel, dvs de första två dagarna inträffade händelsen inte, på tredje dagen inträffade den osv.

0 0 1 0 0 0 0 0 1

Från denna serie får man motsvarande S-värden (tänk på att S återställs till 1 om S < 1 och att S är 1 från början). De första två dagarna blir 1 enligt:

S * 0.8867 = 1 * 0.8867 = 0.8867 < 1, varpå S återställs till 1

Här är en liten tabell för att visa utvecklingen av S-värdet.

H S-värde

0 1

0 1

1 4.285714

0 3.800141

0 3.369583

0 2.987808

0 2.649287

0 2.349122

0 2.082965

1 8.926994

Inget av S-värdena är större än gränsvärdet (50), så ingen varning utfärdas för dessa första 10 dagar. Om händelsen inträffar även nästa dag (dag 11) skulle S-värdet vara 38.25854 (8.926994*4.285714) vilket inte heller ger någon varning. Om den även inträffar påföljande dag (dag 12) skulle det en varning utfärdas eftersom 8.926994*4.285714*4.285714 = 163.9652 >= 50.

Poängen med Pages S-serie är att den stiger kraftigt om händelsen inträffar, men avtar långsamt om händelsen inte inträffar. (Eller snarare: i detta exempel är det "kraftigt", det exakta beteendet beror på de specifika sannolikheterna.)

R-funktionen changepoint

Pages metod har implementerat i statistikpaketet R med följande funktion:

changepoint <- function(x,normal=1/30,non.normal=1/7,detect.value=50,plot=T){

occurs <- non.normal/normal # händelsen inträffar

not.occurs <- (1-non.normal)/(1-normal) # händelsen inträffar inte

S <- 1

vec = NULL # vektor med S-värdena

len <- length(x)

alerted <- FALSE;

cp <- NULL; # changepoint

S.cp <- 0; # värdet för S i changepoint

for (i in 1:len) {

obs <- x[i] # observationen

# justera S enligt metoden:

S <- ifelse(obs, S*occurs, S*not.occurs)

S <- ifelse(S<1,1,S) # reset om mindre än 1

# varna om S-värdet överstiger gränsvärdet

if (plot && !alerted && S >= detect.value) {

cat("Alert! observation #", i, ": ", S, " >= ", detect.value,"\n")

cp <- i; S.cp <- S; alerted <- TRUE

}

vec <- c(vec,S)

}

csum <- cumsum(x) # kummulativa summan av händelseserien

cumsum.val <- 0 # antal observationer

if (!is.null(cp) && cp > 0) { cumsum.val <- csum[cp] }

m<-max(csum) # för grafen

vec.len <- length(vec)

# plotta tre grafer

if(plot) {

op <- par(mfrow=c(3,1)) # plotta grafer

plot(x,type="l",

main=paste("Changepoint value: ", cp, " S-value:", round(S.cp,2) ))

if (!is.null(cp) && cp>0) { lines( rep( cp, 2), 0:1, col="red") }

plot(csum,type="l", main=paste("Cumulative sum. Num obs.:",cumsum.val) )

if (!is.null(cp) && cp>0) { lines( rep( cp, m+1), 0:m, col="red")}

plot(vec,type="l",main=paste("S values. Detect value: ", detect.value) )

abline( rep(detect.value, vec.len), 0:vec.len,col="red")

par(op)

}

# returvärde

list(vec=vec,cp=cp,cumsum.val=cumsum.val);

}

Funktionen har följande argument, där defaultvärdena är bokens exempel.

x: en vektor av respektive dagars värden om händelsen inträffade eller inte (1 eller 0)

normal:. Sannolikheten för att normalfallet inträffar, default 1/30 för att följa boken

non.normal: Sannolikheten för att extremfallet inträffar, default 1/7

detect.value: gränsvärde för changepoint-varning (default 50)

plot: huruvida man ska plotta respektive skriva ut en varning (när man gör flera simuleringar vill man inte att det plottas och håller på).

Följande värden returneras :

vec: vektor med S-värdena

cp: changepoint, dvs den observation där S-värdet överstiger varningsvärdet

cumsum.val: vilket är summan av antalet händelser som inträffat vid changepoint (egentligen endast för att jag ville kolla lite)

När man kör programmet visas tre grafer om man inte angivit plot=F i funktionen (visas nedan).

1) Först händelsegrafen, med 0 för ej inträffad och 1 för inträffad händelse. Den lodräta röda linjen visar changepointen om sådan finns. "S-value" är S-värdet för changepoint.

2) En graf för det kumulativa antalet inträffade händelser, samt en röd lodrät linje för changepoint. "Num. obs" är det antalet inträffade händelser för changepoint.

3) Den tredje grafen visar S-värdena. "Detect value" är gränsen för S-värdet (dvs då man ska slå larm) och visas som en röd vågrät linke. Notera att det kan vara svårt att se linjen om största S-värde är stort.

Körning av R-koden

Här är bokens exempel:

> x = c(0,0,1,0,0,0,0,0,0,1)

> changepoint(x, 1/30, 1/7, 50, T)

$vec

[1] 1.000000 1.000000 4.285714 3.800141 3.369583 2.987808 2.649287 2.349122

[9] 2.082965 8.926994

$cp

NULL

$cumsum.val

[1] 0

Som vi såg tidigare blev det alltså ingen changepoint eftersom S-värdet inte översteg 50. cp är därför NULL och antalet händelser vid changepoint är därför 0.

Graferna ser ut på följande sätt:

Ett mer intressant exempel (slumpat)

Här är ett mer intressant exempel. Det är en längre sekvens som jag helt enkelt slumpar fram med utgångspunkt från exemplets förutsättningar (normalfall resp. extremfall man vill detektera). I ärlighetens namn körde jag funktionen tills det blev en tidsserie med en changepoint.

För de första 30 dagarna inträffar händelsen (1) med sannolikheten 1/30, sedan kommer 30 dagar med sannolikheten 1/7 för 1. Här är slumpfunktionen:

c(sample(0:1,30,prob=c(29/30,1/30),rep=T),sample(0:1,30,prob=c(6/7,1/7),rep=T));

Så kör vi!

> x <-c(0,0,0,0,0,0,0,0,0,0,0,1,0,0,0,0,0,0,0,0,0,0,0,1,0,0,0,0,0,0,1,1,0,0,

0,0,0,0,0,0,0,0,0,0,1,0,1,0,0,1,0,0,0,1,0,0,0,0,0,0)

> changepoint(x)

Alert! observation # 47 : 168.0480 >= 50

$vec

[1] 1.000000 1.000000 1.000000 1.000000 1.000000 1.000000

[7] 1.000000 1.000000 1.000000 1.000000 1.000000 4.285714

[13] 3.800141 3.369583 2.987808 2.649287 2.349122 2.082965

[19] 1.846964 1.637702 1.452150 1.287621 1.141732 4.893139

[25] 4.338744 3.847162 3.411277 3.024778 2.682069 2.378189

[31] 10.192239 43.681023 38.731942 34.343594 30.452447 27.002170

[37] 23.942811 21.230079 18.824700 16.691853 14.800657 13.123736

[43] 11.636810 10.318354 44.221515 39.211196 168.047983 149.008064

[49] 132.125377 566.251614 502.095027 445.207413 394.765194 1691.850832

[55] 1500.163299 1330.194059 1179.482416 1045.846478 927.351557 822.282168

$cp

[1] 47

$cumsum.val

[1] 6

Kommentar: Här ser vi alltså att det blev en varning vid observation #47 (dag 47) och då hade händelsen inträffat totalt 6 gånger. Det var på den 16 dagen (31 + 16 = 47) efter att "extremfallet" började gälla (dvs med 1/7 som sannolikhet). Man kan f.ö. notera att just i denna sekvens blev det 2 stycken händelser efter varandra precis i början på "extremfallet".

Grafen för detta exempel:

Not: Om man kör programmet på ovanstående sätt, dvs batchar hela serien på en gång, så förfelar det sitt syfte. Man ska naturligtvis köra programmet varje dag efter man fyllt i dagens "händelsevärde" och kontrollera om det kommer en varning. Programmet fortsätter alltså att köra efter varningen. I stället borde kanske lampor i lustiga färger börja blinka, sirener börja tjuta och den stora valvdörren börjar stängas så att man måste skynda sig in i valvet innan dörren stängs helt med ett tungt och djupt "swoonk". Minsann kommer där en jeep i högsta fart genom stängslet och fyra personer rusar fram till dörren. Kommer de att klara sig? Ojoj, vad spännade det är...

Andra changepoint-metoder

Pages metod (enligt bokens förklaring och exempel i alla fall) hanterar endast binära tidserier (0/1). Det finns även metoder som detekterar changepoints i tidsserier med numeriska värden. Här nämns några R-funktioner.

Ett standardexempel är datamängden Nile: (via ?Nile i R) Measurements of the annual flow of the river Nile at Ashwan 1871-1970. Det intressanta med denna tidsserie är att år 1898 minskade flödet drastiskt eftersom man byggde första Ashwan-dammen. Kan denna förändring uppptäckas med changepoint detection-metoderna (även kallad "change point analysis", "change detection" etc). Svaret är naturligtvis jakande.

R-paketet struccchange

Med functionen breakpoints() i paketet strucchange visas flera olika changepoints (benämns breakpoints och breakdates för respektive observationsnummer och årtal). Brytpunkterna sorteras på hur stora (viktiga) de är. Nedan ser man att observation 28 (år 1898) är den viktigaste förändringspunkten; det hände också något vid observation 83 (år 1953) etc.

> library(strucchange)

> data(Nile)

> summary(breakpoints(Nile~1))

Optimal (m+1)-segment partition:

Call:

breakpoints.formula(formula = Nile ~ 1)

Breakpoints at observation number:

m = 1 28

m = 2 28 83

m = 3 28 68 83

m = 4 28 45 68 83

m = 5 15 30 45 68 83

Corresponding to breakdates:

m = 1 1898

m = 2 1898 1953

m = 3 1898 1938 1953

m = 4 1898 1915 1938 1953

m = 5 1885 1900 1915 1938 1953

Fit:

m 0 1 2 3 4 5

RSS 2835156.750 1597457.194 1552923.616 1538096.513 1507888.476 1659993.500

BIC 1318.242 1270.084 1276.467 1284.718 1291.944 1310.765

R paketet bcp

Ennan metod är funktionen bcp() från paketet bcp (Bayesian Change Point) som visar sannolikheterna för att de olika observationerna är en förändringspunkter. Den mest sannolika punkten har markerats med ett gäng utropstecken.

> library(bcp)

> Nile.bcp <- bcp(Nile)

> summary(Nile.bcp)

> Nile.bcp

Probability of a change in mean, Posterior Mean,

and SD for each position:

Probability Mean SD

1 0.016 1085.8 14.15

2 0.012 1085.6 14.06

3 0.014 1085.1 13.61

4 0.018 1085.5 13.80

5 0.018 1085.2 14.49

6 0.026 1084.8 15.67

7 0.046 1079.2 37.90

8 0.038 1089.4 29.73

9 0.062 1093.0 40.96

10 0.058 1082.8 26.11

11 0.028 1075.1 25.60

12 0.016 1072.0 27.79

13 0.016 1071.6 27.32

14 0.010 1071.0 28.02

15 0.022 1070.6 28.80

16 0.026 1069.5 30.92

17 0.022 1070.0 30.39

18 0.044 1067.7 38.25

19 0.088 1071.5 35.46

20 0.062 1084.1 29.90

21 0.054 1091.7 29.46

22 0.038 1098.5 31.98

23 0.026 1102.0 32.26

24 0.024 1104.9 34.27

25 0.028 1105.3 36.10

26 0.136 1102.9 36.36

27 0.184 1071.1 77.60

28 0.618 1029.3 108.61 !!!!

29 0.078 869.8 66.26

30 0.034 856.8 40.52

31 0.042 852.5 28.16

32 0.020 849.5 14.42

33 0.022 850.4 14.29

34 0.008 849.9 14.03

35 0.018 849.6 14.19

36 0.018 850.2 14.20

...

Den 28:e observationen har alltså högst sannolikhet. Den sista observationen har sannolikhet 1 och som jag ignorerar. En graf plottas också där man tydligt ser förändringen.

> which.max(Nile.bcp$posterior.prob[-c(100)])

[1] 28

> plot(Nile.bcp)

(För övrigt är detta blogganteckning #1200. Yeay!)

Uppdatering

Håkan Karlsson (aka hakke) uppmärksammade uppmärksamt att "normalfallet" och "extremfallet" hade förväxlats i pratbeskrivningen av hur S uppdateras. Tack hakke.

Posted by hakank at 07:39 EM Posted to Statistik/data-analys | Comments (2)

juli 03, 2007

Några videoföreläsningar om statistik, sannolikhet och data mining

Semester och det blir naturligtvis lite "hängmatte", t.ex. i form av videoföreläsningar.

Så här är några föreläsningar att förgylla sommaren med:

Davis Mease: Statistical Aspects of Data Mining

David Mease om "Statistical Aspects of Data Mining" med R (www.r-project.org) och Excel. Mease har detta även som en "riktig" (IRL inte bara URL) kurs med kurssajten www.stats202.com. Det är lugnt tempo som går igenom grunderna i både teori och verktyg.

Statistical Aspects of Data Mining (Stats 202) Day 1

Statistical Aspects of Data Mining (Stats 202) Day 2

I skrivande stund har endast publicerats ovanstående två föreläsningar. Efterkommande borde dyka upp via denna sökning på video.google.com .

Kursbok är Tan, Steinbach, Kumar: Introduction To Data Mining (ej läst).

Peter Donnelly: How juries get fooled by statistics

Peter Donnelly How juries get fooled by statistics. Visar flera av våra ointuitioner som finns inom området, ofta underhållare på ett traditionellt brittiskt-Grants sätt. Finns även på TEDTalks här.

Beskrivning:

Oxford mathematician Peter Donnelly explores the common mistakes we make in interpreting statistics, and the devastating impact these errors can have on the outcome of criminal trials. Statistical uncertainty and randomness, he says, confound many of our assumptions about the world. He shares the case of a British woman wrongly convicted of murdering her two infants -- a verdict reached, in part, by the misuse of statistics.

[För den som vill läsa mer t.ex. om det där mynt-experimentet finns en relativt djupgående redogörelse i Anirban DasGupta: Sequences, Patterns and Coincidences (PDF).]

Brian Brushwood: Scams, Sasquatch, and the Supernatural

Brian Brushwood Scams, Sasquatch, and the Supernatural. Är mest om debunkning av olika typer av pseudo-vetenskap, men innehåller en akt om sannolikheter (sammanträffanden). Underhållande och med högt tempo.

Ever wonder how those guys on TV seem to talk to the dead? What about ESP and psychic surgery? How do street scams and cons work? Want to ... all » know how YOU can trick your friends into believing you have psychic powers?As a magician, Brian’s wise to all the tricks used by frauds, tricksters, and con artists …and now he’s ready to take YOU to scam school. This is no ordinary lecture: we’re talking hands-on experiments, a live performance of psychic surgery, free giveaways of cash and prizes, and all the secrets TV psychics DON’T want you to know.

Topics covered include: scams, cons, ESP, UFOs, skeptic, skepticism, dowsing, astrology, memory, alternative medicine, psychic surgery, pseudoscience, coincidence, and crop circles.

Relaterat

Persi Diaconis On Coincidence (som jag iofs skrev om för några år sedan men rekommenderar gärna igen).

Talks Hans Rosling: New insights on poverty and life around the world

Talks Hans Rosling: Debunking third-world myths with the best stats you've ever seen

En kul semesterövning är att analysera lottodata från det sydafrikanska lotteriet. Se vidare bloggen Freakonomics: Is the South African Lottery Rigged? A Hands-On Exercise for Bored Blog Readers.

Uppdatering

Äh, jag glömde ju Scott McClouds grafiska novella The Right Number:

The Right Number is a projected three part online graphic novella about math, sex, obsession and phone numbers presented in an unusual zooming format. Click above to read Parts One and Two. (Part Three will hopefully be completed and available before too long.)

(Not: Serien är skriven 2003 så frågan är om det kommer en tredje del. De två första delarna är dock ganska självständiga. Via EconLog.)

(Avslutningsvis - men egentligen helt orelaterat till ovanstående - kan noteras att det för några veckor sedan var 4-årsdagen av denna bloggs födelse, som inträffade helt utan några virtuella tårterier. Referens till tidigare bemärkelseskriverier finns i förra årets 3-årsdag samt en drapa om varför bloggar bör ses som mer än en dagbok.)

Posted by hakank at 10:56 FM Posted to Sammanträffanden | Statistik/data-analys | Video podcasts

februari 11, 2007

Några länkar om dataanalys, data mining etc 20070211

Statistical Modeling, Causal Inference, and Social Science

The fallacy of the one-sided bet (for example, risk, God, torture, and lottery tickets)

Animated Social Network Visualization

Data Mining Research

Data mining application: terrorism, som även tipsar om en ny bok Data Mining and Predictive Analysis: Intelligence Gathering and Crime Analysis (ISBN: 075067796) skriven av Colleen McCue .

Geeking with Greg

Excellent data mining lecture notes tipsade för länge sedan om kursen CS345, Autumn 2006: Data Mining. Där finns en mängd presentationer av metoder.

Cognitive Daily

Is 17 the "most random" number?

Randomness wrap-up

Nyupptäckta bloggar i ämnet

Data Mining Research tipsade även om en ny blogg Crime Analysis and Data Mining: A meeting place for those interesting in analyzing or solving crimes using Predictive Analytics!, se presentationen.

Posted by hakank at 10:37 FM Posted to Machine learning/data mining | Statistik/data-analys

februari 04, 2007

Ultimate Research Assistant (Web Edition)

Ultimate Research Assistant (Web Edition) är en trevlig (men tyvärr långsam) applikation för att sammanställa sökresultat på ett mer intelligent sätt än de sökmotorerna. Systemet listar ut fraser som anses vara signifikanta för sökordet och visar representativa sajter

Exempel: sökning på "blogg" ger följande nyckelord.

- blogg

- att det

- jag har

- att jag

- blogg

- Climate Change

- det som

- för att

- har jag

- jag har

- om att

- om det

- Om man

- som jag

Av ovanstående fraser anses denna blogg vara representativ för flera: "att det", "jag har", "att jag", "om det", "det som", "om man", "som jag". Vilket kan få en att undra...

Vad gäller urvalet av fraser kan man möjligen anta att stackarn blivit förvirrad av innehållet av de 50 första sökresultaten av "blogg" på Yahoo!, eller så är det helt enkelt att - som det heter på julafton - att "Tony förstår inte språket så bra". Intressant nog finns "Climat Change" med, en het potatis i både inom och utanför bloggvärlden.

Sökningar på mer stringenta fackfraser såsom "text mining" (som råkar vara den teknik som Ultimate Research Assistant använder) och "Diaconis" (en husgud som ofta används för testning av sökverktyg) ger betydligt bättre resultat och känns användbart.

Man bör dock notera den brasklapp som står på sajten: It is an experimental proof-of-concept prototype, and should not be used for any official purposes.

Se vidare

Andy Hoskinson:

Creating the Ultimate Research Assistant där tekniken bakom verktyget förklaras.

Samme Hoskinson har även skapat verktyget Keyword Analysis Tool - Advanced Keyword and Keyphrase Extraction Technology for Content Analysis and Search Engine Optimization (SEO).

Wikipedia: Text mining

Tyvärr koms det här även att tänkas på 200 dagar som bl.a. visar förekomsterna av ord på hakank.blogg där ordet "jag" kom på fjärde plats, samt "jag" i bloggen där vidare språkanalyser genomfördes.

(Verktyget funnet via webbserverloggen.)

Posted by hakank at 05:46 EM Posted to Språk | Statistik/data-analys | Comments (4)

januari 26, 2007

The Blog Authorship Corpus

Den som har lust att göra dataanalyser på engelskspråkiga bloggtexter bör kika på The Blog Authorship Corpus:

The Blog Authorship Corpus consists of the collected posts of 19,320 bloggers gathered from blogger.com in August 2004. The corpus incorporates a total of 681,288 posts and over 140 million words - or approximately 35 posts and 7250 words per person....

The corpus may be freely used for non-commercial research purposes.

Zipfilen (nedladdningsbar via ovanstående sida) är 305Mb. Datan uppackad är 840 Mb, bestående av 19320 XML-filer med enkelparsrade taggar såsom <Blog>, <date>, <post>.

Kodningen av författarna görs i filnamnet, t.ex.

3802222.female.13.Student.Gemini.xml, dvs löpnummer, kön, ålder, sysselsättning samt stjärntecken (!).

Det görs en analys i J. Schler, M. Koppel, S. Argamon and J. Pennebaker Effects of Age and Gender on Blogging .

Via Data Mining: Text Mining, Visualization and Social Media

(Det vore trevlig med motsvarande corpus av svenska bloggtexter. Och hellre YYYYMMDD-födelsedata än stjärntecken.)

Posted by hakank at 07:32 FM Posted to Blogging | Statistik/data-analys | Comments (3)

januari 15, 2007

Hur mycket kan man sänka världsrekorden? (extremvärdesanalys)

Daily Time-artikeln World record in 100 metres can be lowered, study predicts diskuterar hur mycket nuvarande världsrekord bör kunna sänkas i olika sportgrenar. Analysen är gjord med den statistiska metoden extremvärdesteori (extreme values).

The world record in the 100-metre sprint can be lowered by another half-second before man reaches his limits, according to an expert in the field of extreme values. The men will hit a wall when Asafa Powell’s current record of 9.77 seconds mark is reduced to 9.29, a study by Prof John Einmahl of Germany’s Tilberg university predicted on Thursday....

Den undersökning som diskuteras är John Einmahl, Jan R Magnus: Records in athletics through extreme-value theory (PDF). Från inledningen:

How fast can humans or cheetahs run? What is the total (insured) loss of hurricane Katrina? Is a specific runway at JFK airport long enough for a safe landing? How high should the Dutch dikes be in order to protect us against high water levels? How long can we live? These questions all relate to extremes. In this paper we shall be interested in two questions on extremes relating to world records in athletics. The first question is: what is the ultimate world record in a specific athletics event

(such as the 100m for men or the high jump for women), given today's state of the art? Our second question is: how `good' is a current athletics world record? An answer to the second question will enable us to compare the quality of world records in diffrent athletics events.

På sidan 12 finns en fin tabell Ultimate world records, their precisions, and the current world

records återspeglad här nedan. Dvs det nuvarande världsrekordet på 100m (män) är 9.77. Enligt analysen ska man kunna pressa ner detta till 9.29.

| Men | Women | |||||

| Event | endpoint | precision | world record | endpoint | precision | world record |

| 100m | 9.29 | 0.39 | 9.77 | 10.11 | 0.40 | 10.49 |

| 110/100m h. | 12.38 | 0.35 | 12.88 | 11.98 | 0.19 | 12.21 |

| 200m | 18.63 | 0.88 | 19.32 | 20.75 | 0.57 | 21.34 |

| 400m | - | - | 43.18 | 45.79 | 1.83 | 47.60 |

| 800m | 1:39.65 | 1.44 | 1:41.11 | 1:52.28 | 1.39 | 1:53.28 |

| 1500m | 3:22.63 | 3.31 | 3:26.00 | 3:48.33 | 2.78 | 3:50.46 |

| 10,000m | - | - | 26:17.53 | - | - | 29:31.78 |

| marathon | 2:04:06 | 57 | 2:04:55 | 2:06:35 | 10:05 | 2:15:25 |

| shot put | 24.80 | 1.25 | 23.12 | 23.70 | 0.86 | 22.63 |

| javelin throw | 106.50 | 10.30 | 98.48 | 72.50 | 2.99 | 71.70 |

| discus throw | 77.00 | 2.85 | 74.08 | 85.00 | 8.10 | 76.80 |

| long jump | - | - | 8.95 | - | - | 7.52 |

| high jump | 2.50 | 0.05 | 2.45 | 2.15 | 0.05 | 2.09 |

Mer om detta

Econometrists Tilburg University Calculate the Ultimate Athletics Records

Den data som används i undersökningen finns tillgänglig från:

* Track Field Athlectics (Hans-Erik Pettersson)

* International Association of Athletics Federations (IAAF)

Mer om den extremvärdesanalys samt introducerande litteraturreferenser finns i Extremvärdesanalys av webbesök.

Posted by hakank at 05:39 EM Posted to Sport, idrott, hälsa | Statistik/data-analys | Comments (1)

oktober 29, 2006

Dagslänkar 2006-10-29 - tema lotterier

Maths theory bags lotto jackpot, via Minding the Planet

CBC News: Lottery retailers enjoying luck of the draw: Fifth Estate probe, via Sabermetric Research

Och varför inte de något relaterade

Lite om konsekutiva talpar i Lotto (och dess varianter).

Littlewood's Law of Miracles -The law of truly large numbers

Posted by hakank at 06:47 FM Posted to Statistik/data-analys

rcompletion: Tab-komplettering i R

I statistik- och dataanalyspaketet R har det funnits tab-kompletteringar (för kommandoradsvarianten) men endast för filnamn. Länge har jag saknat att kunna tab-komplettera funktionsnamn à la Emacs eller Unix-skal.

I morse - i loggen över icke automatinstallerade paket - hittades paketet rcompletion som gör precis detta. Det är inte bara variabelnamn och funktionsnamn som kompletteras, utan man kan även få fram parametrarna i en funktion. Det sistnämnda känns mycket användbart.

En första not

rcompletion funkar endast för kommandoradsversionen av R och endast på system som har libreadline. Se nedan hur man installerar paketet, jag hade nämligen lite problem med detta.

Några exempel

Vi börjar med att ladda in paketet tseries för att testa lite

> library(tseries)

Så börjar vi vår tab-session, där <TAB> alltså betyder tab-tangentens nedtryckande.

> ari<TAB>

som ger följande förslag:

arima( arima0( arima0.diag( arima.errors( arima.sim(

Varpå vi sedan tabbar inom en funktion, dvs inklusive första parentesen och får listan över funktionens parametrar.

> arima(<TAB>

fixed = kappa = n.cond = seasonal = xreg =

include.mean = method = optim.control = transform.pars =

init = model = order = x =

Nifty!

Mixtrande med installationen av rcompletion (version 0.8) hos mig

Tyvärr så var jag tvungen att mixtra lite för att kunna installera paketet. Anledningen till att det inte gick in vid automat-installationen (via R:s normala install.packages()) var att konfigurationen inte tyckte att min dator har libreadline.so, vilket ju är väldigt felaktigt.

Varpå följande gjordes:

1) ladda ner paketfilen (via paketets sida sida)

2) manuellt packa upp paketfilen i lämplig katalog (tar zxcv paketnamnet)

3) i katalogen som skapades finns filen configure. På ungefär rad 2287 (för version 0.8) finns dessa rader som utan pardon kommenterades bort enligt följande:

# if test $ac_cv_lib_readline_rl_completion_matches = yes; then

PKG_CFLAGS="${PKG_CFLAGS} -DHAVE_LIBREADLINE"

PKG_LIBS="${PKG_LIBS} -lreadline"

#else

#

# { { echo "$as_me:$LINENO: error: readline is required but was n\ ot found" >&5

#echo "$as_me: error: readline is required but was not found" >&2;}

# { (exit 1); exit 1; }; }

# exit 1

#

#fi

dvs raderna med PKG_CFLAGS och PKG_LIBS ska vara kvar.

4) efter detta installerar man paketet manuellt (eventuellt som root om R är så installerat).

R CMD INSTALL paketnamn

5) I R laddar man paketet som vanligt med library(rcompletion)

Paketförfattaren är medveten om att det finns problem och skriver mer här.

Uppdatering torsdag 11 nov 2006

Installationsproblemet ser ut att ha löst sig. Paketet installeras nu helt sömlöst.

Posted by hakank at 06:22 FM Posted to Statistik/data-analys

juni 08, 2006

Vilken boll är rundast? Slumpmässighet i sporter

I P1 pratades precis om att fotboll är den mest slumpmässiga sporten. Matematikern som intervjuades, Torbjörn Lundh, har skrivit Which ball is the roundest? – a suggested tournament stability index (PDF).

Abstract:

All sports have components of randomness that team not to win every game. According to many spectators of the charm when following a competition or a match. less of this unpredictability? We suggest here a general stability index, which could measure this randomness factor and different sports. As an illustration we use exemplify squash, and soccer. Results will also be given on tournaments football, ice-hockey, and handball. Furthermore, we will optimization questions that turned up on the way.

(Funnen via sidan Vetenskapsfestival 2006)

Uppdatering

Intervjun kan (förhoppningsvis) ålyssnas via följande djuplänk.

Malin på Vetenskapsnytt skrev i vintras (onsdag, januari 04, 2006) om en liknande undersökning: Fotboll är den mest spännande sporten, säger forskare, där följande paper omnämns:

E. Ben-Naim, F. Vazquez, S. Redner What is the most competitive sport? (arXiv.org)

We present an extensive statistical analysis of the results of all sports competitions in five major sports leagues in England and the United States. We characterize the parity among teams by the variance in the winning fraction from season-end standings data and quantify the predictability of games by the frequency of upsets from game results data. We introduce a mathematical model in which the underdog team wins with a fixed upset probability. This model quantitatively relates the parity among teams with the predictability of the games, and it can be used to estimate the upset frequency from standings data. We propose the likelihood of upsets as a measure of competitiveness.

Andra bloggar om: matematik, sport.

Posted by hakank at 07:42 FM Posted to Matematik | Sport, idrott, hälsa | Statistik/data-analys | Comments (3)

januari 23, 2006

Något om prefixträd sorterade på lite olika sätt samt komprimering

Av en privat (och personlig) orsak behövdes ett program för att skapa unika prefix av ord i en lista, och sedan att presentera dessa prefix som ett träd. Anledningen var ungefär att korta ner en lista av ord till kortare ord (dess prefix).

Ett exempel på ett sådant prefixträd är för de svenska månadsnamnen:

a:

ap: april

au: augusti

d: december

f: februari

j:

ja: januari

ju:

jul: juli

jun: juni

m:

ma:

maj: maj (!!!)

mar: mars

n: november

o: oktober

s: september

Här ser vi t.ex. att månadsnamnen december, februari och november kan komprimeras till en enda bokstav, medan april och augusti båda börjar på bokstaven a så vi måste här ta till en extra bokstav för att skilja dem åt. Man kan också notera att maj inte blev något prefix alls, utan här behövs hela ordet eftersom mars, den rackaren, ligger och stör. Sådana fall markeras med !!!!

Program Prefix Trees

Det har naturligtvis skapats ett program för att kunna leka vidare med sådana här ord-listor, och som - möjligen något missledande - kallas för Prefix trees.

Programkörningen för ovanstående svenska månadsnamen finns ungefär här.

Komprimering och annat skoj

Även om det primära syftet med programmet var att skapa unika prefix och prefixträd så var det svårt att låta bli att studera vissa saker i mer detalj.

Om man kör programmet för de svenska månadsnamnet kommer det, förutom det fina prefixträdet, även lite statistik (längst ner på sidan):

...

Original total length of words: 74

Total length of prefixes: 23

Mean prefix length: 1.92

Compression factor (original length/prefix length): 3.217

Man kan bl.a. se att det medellängden av de skapade prefixen är 1.92, vilket ska jämföras med medellängden av de ursprungliga orden på 6.17. Komprimeringsfaktorn är 3.217, vilket räknas ut med formeln

(sammanlagda längden av original orden) / (sammanlagda längden av prefixerna)

Dvs: genom att använda de unika prefixen istället för de hela orden sparar man en hel del, t.ex. träd (sic!) om man skulle använda papper för att skriva dem. Det kanske blir svårt att läsa det, men man skulle kunna spara både tid och pengar på detta. Nedan kommer vi att studera hur man kan spara något mer tid/papper/pengar men i gengäld blir det i stort sett oläsbart...

Frekvenssortering av bokstäver

En finess med programmet är att man kan studera lite olika varianter av representation av orden innan det skapas prefix. T.ex.

- bokstäverna i ordet sorteras innan man gör prefixen, valet Sort (plain)

- bokstäverna i ordet sorteras i omvänd ordning, valet Reverse. Not: om man både sorterar och reverse, blir det i omvänd sorteringsordning, dvs "ö" kommer före "ä" etc.

Sedan den mest intressanta varianten: bokstavsfrekvenssortering (valet Sort by letter frequency, som innebär att innan man skapar prefixen sorterar man ordets bokstäver i ordning av hur vanliga/sällsynta bokstäverna är bland samtliga ords bokstäver. T.ex. så är det troligt att bokstaven "z" är sällsynt vilket gör att ett ord med "z" kommer att prefixas som z + eventuellt någon annan bokstav.

Om vi fortsätter med månadsnamnsexemplet får man med bokstavsfrekvenssortering följande prefixträd:

d: december

f: februari

g: augusti

j: maj

k: oktober

l: juli

n:

nj:

nju:

njui: juni

njuia: januari

p:

pl: april

ps: september

s: mars

v: november

....

Original total length of words: 74

Total length of prefixes: 21

Mean original length: 6.17

Mean prefix length: 1.75

Compression factor (original length/prefix length): 3.524

Om man jämför med det "vanliga" prefixträdet så är komprimeringsfaktorn något lägre för bokstavsfrekvenssorteringsvarianten (3.524 jämfört med 3.217).

Denna skillnad tenderar att vara beständigt: Detta innebär att om man använder bokstavsfrekvenser istället blir det något bättre komprimering. Nackdelen är naturligtvis att "förkortningen" (prefixet) är fullständigt obegriplig. Se även en mer systematisk genomgång nedan.

Några noter kring detta

Möjligen skulle man här kunna göra en analogi med Huffman-kodning (ref till en.wikiedia) som skapar binära koder efter bokstävernas frekvens, där den kortaste koden tilldeleas den vanligaste bokstaven etc.

En mer avancerad variant av prefixträd skulle vara att analysera prefixträdet för att komprimera det ännu mer.

Det går naturligtvis också att göra det väldigt enkelt för sig och koda varje ord till ett eller flera fullständigt slumpmässiga tecken alltefter ordens/bokstävernas frekvens i texten. Men det är en övning som lämnas åt vidare öden (eller övning åt läsaren/skribenten).

Den ursprungliga poängen med prefixträden var att de skulle vara lätta att skapa och (relativt) lätt att uttyda när man ser dem. När man använder sorteringar av olika slag förloras detta syfte bort i skymningen varvid endast nästa dags solstrålar är glada att se det.

Liten undersökning

Det gjordes också en undersökning hur antalet olika ord i listan påverkar komprimeringsfaktorn respektive medelprefixlängden. Detta gjordes för ett olika antal slupmässiga svenska ord (ur en ordlista på nästan 400000 ord).

Det visar sig - inte speciellt förvånande - att ju fler slumpmässiga ord listan innehåller, desto sämre blir komprimeringsfaktorn och desto längre blir medellängden på prefixen. Som variansen visar är det relativt stabila värden förutom för den första körningen (10 ord i listan). Av tidsskäl kördes endast 10 gånger med samma liststorlek.

Prefix utan någon bokstavssortering

| Antal ord | Komprimeringsgrad | Komprimeringsgrad varians | Prefix medellängd | Prefix medellängd, varians |

| 10 | 7.80730 | 4.67526 | 1.47000 | 0.12456 |

| 100 | 4.14080 | 0.02874 | 2.63700 | 0.00842 |

| 200 | 3.54860 | 0.03530 | 3.11500 | 0.01812 |

| 500 | 3.04260 | 0.00201 | 3.60800 | 0.00775 |

| 1000 | 2.70590 | 0.00199 | 4.10200 | 0.00368 |

| 2000 | 2.39940 | 0.00078 | 4.60200 | 0.00717 |

| 3000 | 2.23620 | 0.00063 | 4.96000 | 0.00207 |

| 5000 | 2.06810 | 0.00030 | 5.36400 | 0.00158 |

| 10000 | 1.84500 | 0.00009 | 5.99800 | 0.00057 |

| 20000 | 1.65400 | 0.00002 | 6.68800 | 0.00040 |

| 50000 | 1.44040 | 0.00001 | 7.68000 | 0.00031 |

| 100000 | 1.31520 | 0.00000 | 8.41300 | 0.00020 |

Prefix med frekvensbokstavssortering

| Antal ord | Komprimeringsgrad | Komprimeringsgrad varians | Prefix medellängd | Prefix medellängd, varians |

| 10 | 9.68830 | 4.15306 | 1.15000 | 0.02500 |

| 100 | 4.24470 | 0.02675 | 2.56800 | 0.01280 |

| 200 | 3.81910 | 0.02128 | 2.94800 | 0.00544 |

| 500 | 3.26520 | 0.00193 | 3.40900 | 0.00283 |

| 1000 | 2.89340 | 0.00351 | 3.83500 | 0.00372 |

| 2000 | 2.61810 | 0.00032 | 4.24200 | 0.00044 |

| 3000 | 2.47130 | 0.00082 | 4.48900 | 0.00159 |

| 5000 | 2.28780 | 0.00018 | 4.82100 | 0.00054 |

| 10000 | 2.06480 | 0.00009 | 5.36200 | 0.00042 |

| 20000 | 1.87310 | 0.00003 | 5.91000 | 0.00018 |

| 50000 | 1.65010 | 0.00001 | 6.70800 | 0.00008 |

| 100000 | 1.50710 | 0.00000 | 7.34400 | 0.00014 |

Andra exempel